ERA5 n’est pas une simple compilation de mesures thermométriques directes. C’est une réanalyse produite par l’ECMWF (Centre européen pour les prévisions météorologiques à moyen terme), qui combine :

- Des observations réelles (stations météo, satellites, radiosondages, etc.),

- Un modèle numérique d’assimilation de données (4D-Var),

- Des lois physiques pour combler les lacunes spatiales et temporelles.

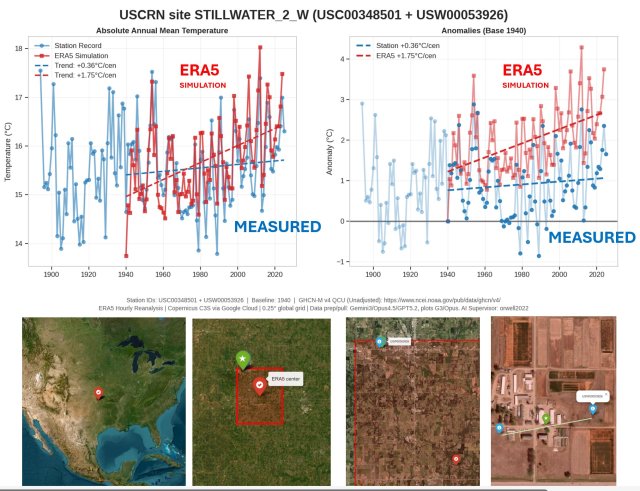

Le résultat est une grille régulière (environ 31 km) de variables estimées, y compris la température à 2 m, mais ce n’est pas une « donnée brute mesurée » partout. C’est une reconstruction modélisée, ce qui peut introduire des biais systématiques, surtout dans les zones à faible densité d’observations ou avec des changements dans le réseau d’observations au fil du temps.Concernant votre test spécifique (comparaison grille ERA5 vs USCRN aux États-Unis) :

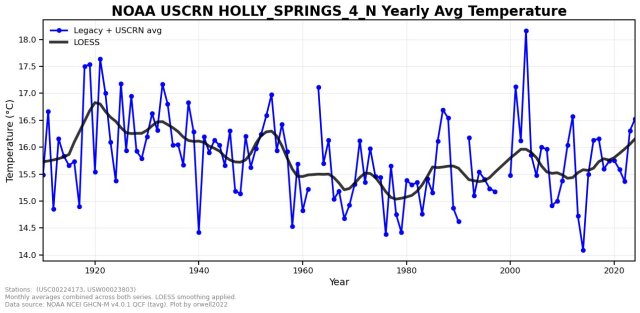

- USCRN (United States Climate Reference Network) est un réseau de stations très bien maintenu, implanté dans des sites ruraux/pristins depuis ~2001-2005, avec une instrumentation de haute qualité et minimisant les biais d’urbanisation ou de relocalisation. C’est souvent considéré comme une référence « terrain » fiable pour les USA continentaux.

- Plusieurs études montrent que les réanalyses comme ERA5 présentent des biais de température en surface, variables selon les régions, les saisons et les périodes :

- En général, ERA5 a tendance à être plus chaud que certaines observations dans des contextes spécifiques (par exemple, en Arctique sur la glace de mer, ou dans des zones complexes topographiquement).

- Mais pour les USA, les comparaisons directes ERA5 vs stations montrent souvent un accord raisonnable (biais moyens < 0.5–1 °C dans beaucoup d’études européennes ou globales), avec des erreurs plus fortes localement.

Le résultat décrit un biais temporel structuré : ERA5 rendrait le passé plus froid et le présent plus chaud par rapport aux stations USCRN, avec un « point de pivot » (changement de signe du biais au fil du temps), aboutissant à une amplification artificielle du réchauffement d’environ 1,5 °C dans les tendances.C’est une critique sérieuse et récurrente dans certains cercles sceptiques : les réanalyses pourraient artificiellement accentuer les tendances récentes à cause de :

- L’amélioration progressive des observations assimilées (plus de satellites, meilleurs instruments depuis les années 2000),

- Des corrections de biais variationnelles (VarBias) qui évoluent,

- Une dépendance croissante aux modèles quand les observations directes sont moins denses dans le passé.

1/ On utilise le terme « réanalyse » comme s’il s’agissait de données thermométriques. Ce n’est PAS le cas.

La réanalyse est un modèle informatique météorologique.

Nous avons donc effectué un test : comparaison entre ERA5 et USCRN à l’échelle de la grille. Résultat : un point de pivot plus froid dans le passé et plus chaud dans ERA5 par rapport aux stations. Modèle ❌

~1,5 °C 🔴 erreur du modèle par rapport à la vérité terrain (mesurée 🔵 )

Nous essayons deux autres paires. Le bâton de hockey finira bien par se révéler quelque part, non ?

Non. Pas là.

Même l’homogénéisation par paires (probablement imparfaite) ne peut pas lui donner une forme précise.

Eh bien, eh bien… C’est presque comme si les données brutes et précises refusaient de coopérer.