Ce document, censé proposer une stratégie nationale contre la désinformation en santé, repose sur 156 entretiens avec 270 acteurs (267 uniques après déduplication). Mais, qui compose vraiment ce panel ? À partir de leurs profils publics – un profilage a été effectué par IA pour chaque personne interrogée sur plusieurs critères :

- Le LancetGate : ont-ils oui ou non identifié les biais du lancetgate en 2020 avant sa rétractation ?

- L’étude ReCoveRy : ont-ils oui ou non dénoncé les biais de l’étude ReCoVery sur l’hydroxychloroquine (doses toxiques sur des patients hospitalisés) ?

- Position sur la vaccination en général : ont-ils une idéologie pro-vax déclarée ?

- Position sur la vaccination covid-19 : ont-ils soutenu ou non la campagne de vaccination covid ?

- Existence des effets secondaires de la vaccination : ont-ils nié l’existence d’effets secondaires des vaccins covid-19 ?

- Position publique sur Robert Kennedy Jr secrétaire d’État à la Santé américain : ont-ils pris ou non une position sur RFK Jr en le traitant d’antivax, antiscience ou complotiste

Le premier critère évalue si la personne ou son institution a identifié a priori la fraude du LancetGate (article rétracté en 2020 sur l’hydroxychloroquine, basé sur des données falsifiées). Ce scandale a eu des répercussions mondiales, influençant des interdictions prématurées en France.

Aucune des personnes interviewées n’avait émis de réserve sur cette étude rétractée en 14 jours en 2020 qui entraina l’arrêt des recherches sur l’hydroxychloroquine alors que les trop nombreux biais de cette étude pouvaient être identifiés rapidement. Et, aucun des répondants n’a contacté Mandeep Mehra l’auteur principal de l’étude.

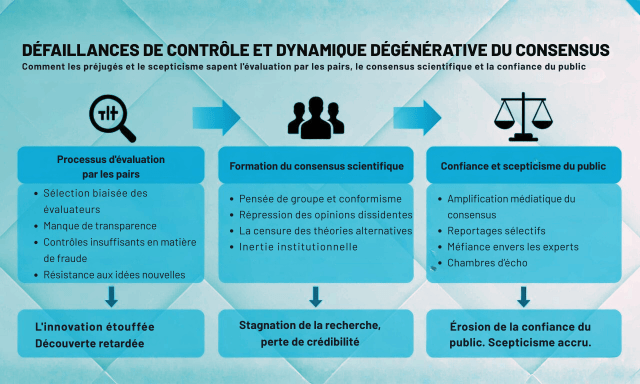

Parmi ce panel, on observe un tropisme vers une absence de détection proactive (83 %) qui illustre un biais de confiance institutionnelle ou encore des prises de positions publiques « pro-lancet » qui ont entrainé une désinformation.

Des organisations comme l’AFP ou des figures comme Alain Fischer ou Olivier Véran, issues d’académies ou d’anciens ministères, ont soutenu initialement l’article, minimisant la fraude. Cela questionne l’indépendance du panel : comment lutter contre la désinformation si l’on ignore les échecs des revues dites « prestigieuses » et que l’on tombe dans un biais de confirmation ou un argument d’autorité ?

Didier Raoult répond aux journalistes qui fantasment sur les délires de Molimard et d’Ariane Anderson

Publié le 5 janvier 2024 par pgibertie

Mathieu Molimard vient de rejoindre Ariane Anderson au panthéon des études frauduleuses . Après le Lancetgate, le Molimardgate https://t.co/7SUsGsbnVg Ils ont osé! Utiliser la surmortalité provoquée par un surdosage toxique (4 à 12 fois les recommandations d’hcq) puis multiplier ce … Lire la suite →

ATTENTION LES LIENS CI DESSOUS RENVOIENT A LA CARRIERE DE LA CHERCHEUSE QUI A CONVAINCU VERAN … C EST CHAUD

http://www.promotelive.com/talent-profiles/ariane-anderson/

Révélée par « Le Canard Enchaîné » le 21 décembre 1983, l’affaire des avions renifleurs demeure à ce jour l’un des plus grands scandales politico-financiers de la Vème République. Quand l’Etat se fait berner par trois escrocs.Quarante ans après, c’est autour de la Macronie avec le Lancet

L’affaire du Lancet servira t elle de leçon à ceux qui dénoncent les « fake news « des réseau sociaux ? Les historiens se souviennent qu’au milieu des années 2000 les Américains furent informés des réalités de l’intervention de Bush en Irak par les réseaux sociaux alors que les médias traditionnels les enfumaient . Aujourd’hui les « Bien pensants » soutenus par Facebook censurent et les chasseurs de fausses nouvelles de Libé et du Monde décident de ce qui sera juste.

Qui aurait pu concevoir qu’en France la santé de la population soit menacée par pure idéologie : Trump soutenait l’hydroxychloroquine et comme, Trump est dangereux, l’hydroxychloroquine est dangereuse . Telle est la redoutable rigueur scientifique qui conduit nos « Bien pensants » à nier les évidences…

Pour ceux qui doutent encore, M Plaza nous fournit un article redoutable.

L’auteur, Peter Ellis, est un scientifique australien spécialiste de l’analyse de données. Il a analysé par le menu le CV de la société Surgisphere de l’Illinois et de QuartzClinical qui est censé renvoyer les données à Chicago.

http://freerangestats.info/blog/2020/05/30/implausible-health-data-firm

Il écrit «Je me sentirais mal d’écrire un article aussi long et agressif si je me trompais. Mais cela semble très improbable. Il est affreux de penser que l’explication la plus probable de ce que nous voyons est simplement que les données ont été fabriquées, et que le processus de publication scientifique est tellement endommagé que l’article est passé» .

«Lorsque j’ai réalisé que les données de l’étude du Lancet avaient probablement été fabriquées, je ne pouvais rien faire d’autre qu’écrire un article de blog à ce sujet. Non seulement Surgisphere est beaucoup trop petit pour avoir des programmes dans 671 hôpitaux, mais les prix et récompenses qu’ils affichent sont douteux.

Dans un sens, il serait encore plus choquant que les données n’aient pas été fabriquées. Si les hôpitaux confiaient nos données de santé les plus sensibles à cette startup pour analyse sans examen éthique ou autorisation (ou protection RGPD) ce serait encore pire».

*

Les données représenteraient les résultats de traitement et de santé de 96 032 patients de 671 hôpitaux sur six continents. Cependant, il n’y a tout simplement aucun moyen plausible de penser que les données sont réelles.

Je le répète – je crois qu’avec une très grande probabilité, les données derrière cette étude de Lancet très médiatisée et à conséquences importantes sont complètement fabriquées .

Si Surgisphere peut nommer les 671 hôpitaux participants ou prouver autrement que les données sont réelles, je retirerai cette déclaration, supprimerai ce message ou rédigerai toutes les excuses humiliantes qu’ils souhaitent. Mais je pense qu’il n’y a presque aucune chance que cela se produise.

Surgisphere pourrait-il vraiment avoir des données sur les patients de 671 hôpitaux?

Je suis loin d’être le premier à demander plus d’informations sur cette incroyable nouvelle base de données dont personne n’avait entendu parler, et ils ont eu une semaine pour expliquer. Voici ce qu’ils ont trouvé:

Le registre Surgisphere est une agrégation des dossiers de santé électroniques désidentifiés des clients de QuartzClinical, le programme d’apprentissage automatique et la plate-forme d’analyse de données de Surgisphere.

Surgisphere s’intègre directement aux DSE de nos clients hospitaliers pour leur fournir des informations exploitables sur les données afin d’améliorer l’efficience et l’efficacité. Dans le cadre de ces accords clients QuartzClinical, Surgisphere, en tant que collaboration mondiale de données sur les soins de santé, est autorisée à inclure les données de DSE de ces hôpitaux dans son registre / base de données interrogeable de rencontres de patients en temps réel et en temps réel.

Courtney l’éditeur scientifique de l’étude Lancet n’avait jamais publié d’étude scientifique auparavant, mais était connue comme écrivain de « science-fiction et fantasy ».

…

Bien que nos accords d’utilisation des données avec ces institutions nous empêchent de partager des données au niveau des patients ou des noms de clients, nous sommes en mesure d’effectuer des analyses appropriées et de partager les résultats agrégés avec la communauté scientifique au sens large.

(«DSE» est le dossier de santé électronique, c’est-à-dire les données personnelles des patients). Franchement, cela ne passe pas le test du rire.

Je peux imaginer pourquoi des clients des hôpitaux ne voudraient pas être nommés, car s’il s’avérait qu’ils permettaient à leurs données d’aller à l’Illinois d’être analysées à volonté – l’article du Lancet dit qu’il était «jugé» qu’une approbation éthique n’était pas nécessaire – il y aurait sûrement un tollé. Ce serait un scandale beaucoup plus important que Facebook qui a fourni des données à Cambridge Analytica. Après tout, ce que nous publions sur Facebook a été perçu par beaucoup de gens comme quasi public. Imaginez que vos dossiers de santé électroniques – données démographiques des patients, antécédents médicaux, médicaments, allergies, résultats de laboratoire, résultats de radiologie – soient remis à Cambridge Analytica .

Et le fait que les hôpitaux ne soient pas nommés par Surgisphere signifie qu’aucun patient d’un hôpital dans le monde ne sait si leurs données sont utilisées ou non dans cette étude.

À droite, regardons Surgisphere. Surgisphere compte cinq employés avec des comptes LinkedIn. Outre le CE et co-auteur du journal Lancet, ce sont un vice-président du développement commercial et de la stratégie, un vice-président des ventes et du marketing et deux rédacteurs scientifiques). LinkedIn enregistre également un employé de QuartzClinical – un directeur du marketing des ventes.

Ariane Anderson, la Directrice des Ventes de SurgiSphere / QuartzClinical… est en réalité un mannequin qui travaille dans l’événementiel

Certains évoquent une actrice porno… du même nom et de la même région

Voici quelques-unes des personnes auxquelles vous pourriez vous attendre à travailler pour une véritable collaboration mondiale de données sur les soins de santé, qui avait vendu des logiciels à 671 hôpitaux et intégré à leurs systèmes de dossier de santé électronique (DSE), et qui coordonne une collaboration internationale de recherche en santé en cours:

- gestionnaire de réseau mondial et coordinateurs

- équipe de liaison hôpital / client

- personnel de soutien / service d’assistance

- formateurs et développeurs de matériel de formation

- des chercheurs

- équipe juridique pour traiter des questions de confidentialité et de contrat dans le traitement de plus de 670 hôpitaux. Les questions émanant du seul RGPD de l’UE occuperaient une équipe juridique substantielle, j’en suis sûr.

- développeurs de logiciels ou de bases de données. Comme, peut-être un ou deux humbles développeurs d’extrait-transformation-chargement pour obtenir ces milliards de lignes de données de transactions dans une base de données.

- administrateurs de bases de données et ingénieurs de données

- Spécialistes des solutions d’intégration de DSE

- responsable de la gouvernance des données

- si l’un des éléments ci-dessus est externalisé, une équipe d’approvisionnement pour gérer tous les sous-traitants

Surgisphere ne compte aucune de ces personnes, à l’exception de Sapan Desai qui fait également office de directeur général et de chercheur médical (une bonne indication de la taille de l’entreprise – la plupart des EC ne sont pas également des chercheurs de publication actifs). À en juger par son profil LinkedIn, son équipe est composée de trois directeurs commerciaux et de deux rédacteurs scientifiques.

Surgisphere ou aucun de ses collaborateurs n’est également présent sur GitHub. Ni une explication nulle part de l’impressionnante ingénierie des données qui serait nécessaire pour brouiller toutes ces données. Ni des articles de journaux, des articles de conférence ou même des articles de blog décrivant son réseau, les API qui le connectent, à quel point ils sont fiers de leur cluster Hadoop sur AWS, quelle plate-forme de base de données qu’ils utilisent, etc etc etc – toutes les choses que de vraies entreprises ont faites des innovations impressionnantes (comme la première base de données mondiale de données hospitalières au niveau mondial, si elle était réelle).

Pourtant, Surgisphere prétend avoir vendu des logiciels à 671 hôpitaux. Combien en coûterait-il pour déployer un logiciel d’analyse de données d’apprentissage automatique dans un hôpital et l’intégrer au DSE? Ce n’est pas une intégration légère et facile comme installer un package de statistiques sur un PC et lui donner une connexion ODBC à une base de données. L’intégration aux systèmes de DSE et la façon dont nous savons qu’ils utilisent les données signifie, au minimum, l’envoi de toutes les données vers le cloud. Cela signifie que vous devez traiter avec des architectes de réseau et de sécurité, disposer de tests extrêmement robustes, d’une sécurité à toute épreuve (rappelez-vous, certaines des données sensibles gardées les plus proches au monde), passer par qui sait ce que la paperasse dans chaque hôpital en termes de convaincre leurs gens de gouvernance des données de ce que vous faites.

Je ne sais pas, mais 1 million de dollars par déploiement ne peut pas être loin du compte. Certainement pas moins de 300k $ pop. Donc, Surgisphere devrait être une entreprise d’un milliard de dollars si cela se fait 670 fois, mais ce n’est clairement pas le cas. En fait, Dun et Bradstreet estiment ses revenus à 45 245 $. Vous ne pourriez même pas faire la phase de découverte d’un projet d’intégration de DSE dans un seul hôpital pour cela, sans parler de déployer quoi que ce soit.

Bien sûr, l’intégration du DSE est une chose réelle, et elle est généralement effectuée pour déplacer les informations des patients en toute sécurité. Par exemple, un rapide Google a trouvé cette présentation utile sur l’intégration du DME (DME et DSE sont essentiellement des termes interchangeables) dans la région des Grands Lacs. Je remarque que Surgisphere est manifestement absent de la liste des présentateurs de la diapositive 10. Cela rend assez surprenant (mais pas vraiment) qu’ils prétendent dans l’article du Lancet avoir des données sur la plupart des cas hospitaliers COVID-19 en Amérique du Nord diagnostiqués avant le 14 avril. 2020 – 63 315 de ces cas dans l’étude selon le tableau S1 , ce qui aurait été une nette majorité de tous les cas hospitalisés.

Qu’en est-il du logiciel QuartzClinical?

Qu’en est-il de ce logiciel QuartzClinical qui aurait été vendu à 671 hôpitaux et qui renvoie les données à Chicago? Il a son propre site Web . Il prétend utiliser «l’apprentissage automatique et l’analyse statistique avancée» pour aider à la prise de décision. Remarquablement, il «intègre avec succès votre dossier de santé électronique, votre système financier, votre chaîne d’approvisionnement et vos programmes de qualité sur une seule plateforme». Révisons mon estimation de 1 million de dollars à 10 millions de dollars sur trois ans, au minimum, si cela signifie que vous remplacez ces choses par une seule plate-forme. Mais cela signifie probablement simplement un entrepôt de données qui tire parti de vos différentes sources de données, et qui a une couche analytique et un moteur de recommandation au-dessus. Des trucs simples de business intelligence, mais toujours un gros projet pour un hôpital.

Je ne peux pas en dire plus car le site QuartzClinical est très léger sur les détails. Il n’a pas de témoignages de clients. Il ne parle pas de ce qui se cache sous le capot. Il ne contient aucune information sur les versions ou l’historique ou la feuille de route à suivre. Il ne demande à avoir remporté quelques prix bien. Voyons voir:

- «Grand prix de qualité, 39e Congrès mondial des hôpitaux de la Fédération internationale des hôpitaux 2015». Non , cela est allé au Texas Children’s Hospital pour «Advanced Population Health – the critical role of care delivery systems».

- «Deuxième prix du Dr Kwang Tae Kim Grand Award, Fédération internationale des hôpitaux 41e Congrès mondial des hôpitaux, 2017». Non , les deux mentions honorables étaient «Atteindre une grande fiabilité grâce à la coordination des soins pour les patients qui nécessitent une intervention chirurgicale d’urgence» par le Northwest Community Hospital, États-Unis et «l’application de l’amélioration du système d’alerte clinique pour réduire l’événement d’arrêt cardiaque inattendu à Taiwan (Hôpital général de Yuan, Taïwan). Aucun de ceux-ci ne ressemble à quelque chose dont QuartzClinical aurait fait partie.

- «Institute for Healthcare Improvement – Four of the Best from the IHI Scientific Symposium (2017).» Je n’ai pas pu trouver ce «prix», il est donc possible qu’ils se soient vraiment retrouvés dans la liste des «quatre des meilleurs». La seule mention de Quartz Clinical sur le site ihi.org est en tant qu’exposant au symposium 2018 . Il est possible qu’ils aient également exposé un an plus tôt et aient obtenu une sorte de reconnaissance.

- Prix McKesson Quest for Quality de l’American Hospital Association pour 2017. Ce prix est allé au Memorial Medical Center de Springfield en Illinois . D’après leur description de la façon dont ils ont gagné, je ne vois rien qui semble lié à un logiciel comme QuartzClinical. Au lieu de cela, ils ont fait des choses comme changer le processus de traitement des fractures de la hanche et ont placé des mains courantes dans les chambres d’hôpital. Cependant, selon son profil LinkedIn, le PDG de Surgisphere, Sapan Desai, a travaillé pour le Memorial Medical Center de mi-2014 à mi-2016 en tant que directeur de «Quality Alliance and Predictive Analysis», il est donc plausible qu’il ait joué un rôle dans le programme qui les a amenés à remporter le même si QuartzClinical n’était pas impliquée.

- Frost et Sullivan Healthcare Innovation Technology Award 2019. Oui , celui-ci Surgisphere semble avoir vraiment gagné . Cependant, la page Wikipedia de Frost et Sullivan dit que ces récompenses sont « basées sur des recherches utilisant une méthodologie propriétaire, qui est parfois basée sur un seul article produit par le destinataire du prix », les décrivant comme un prix de vanité que le bénéficiaire paie des frais pour communiquer. Je ne peux pas juger cela.

En plus de ces cinq récompenses, il y a ce communiqué de presse disant que Sapan Desai «a reçu une mention honorable pour ses réalisations exceptionnelles en matière de qualité et de sécurité des patients, de responsabilité sociale des entreprises, d’innovations dans la prestation de services à un coût abordable, de leadership en soins de santé et de pratiques de gestion »Lors de la cérémonie du Grand Prix Dr. Kwang Tae Kim de l’IHF à Taipei, Taiwan en 2018. Cela semble faux. Les prix du Dr Kwang Tae Kim sont destinés aux hôpitaux et aux organisations de soins de santé , et non aux particuliers. Les cinq mentions de Sapan Desai sur le site Web de l’IHFse rapportent à lui donnant des conférences, il n’y a aucune mention de lui obtenir un prix. Le fait que son propre communiqué de presse annonçant sa «mention honorable» ne renvoie à aucune source faisant autorité pour cela est suspect en soi.

Donc, une affirmation correcte (Frost et Sullivan), une exagérée (le prix du Memorial Medical Center, qui n’était pas pour QuartzClinical mais était au moins un prix, avec un lien plausible avec Desai), trois apparemment faux (concernant la Fédération internationale des hôpitaux) et un incertain (l’Institute for Healthcare Improvement).

J’ai été particulièrement intrigué par le Grand Prix de la Qualité IHF 2015. Cela semble être une revendication si spécifique et facilement réfutable, et en plus d’être sur le site QuartzClinical, elle est répétée par Sapan Desai en tant qu’individu, par exemple dans sa biographie pour cet événement en 2018 – «Il est le destinataire du grand prix international de la qualité des soins de santé par la Fédération internationale des hôpitaux en 2015. » Travaillait-il peut-être au Texas Children’s Hospital? (non, il ne l’était pas).

Puis je suis tombé sur cette pièce réclamant un «prix de qualité supérieure» lors de ce 39e congrès de l’IHF 2015. Malgré le titre, le texte rapporte que Desai a reçu le «premier prix de la meilleure présentation», pour son «Amélioration du succès de la gestion stratégique utilisant le Big Data». Il n’y a aucune trace de ce prix sur le site de l’IHF, bien qu’il ait certainement fait cette présentation. Il est plausible qu’il ait reçu un prix pour la meilleure présentation. Je pense maintenant qu’à un moment donné dans la garniture de CV ultérieure, cela a évolué pour devenir le «Grand prix de la qualité des soins de santé».

Ma meilleure supposition est que les autres réclamations apparemment fausses de récompenses, si elles ont un fondement, sont des exagérations de récompenses de conférence ou des mentions honorables pour des discussions qui ont été exagérées en récompenses importantes pour des logiciels.

Sinon, comment pourrions-nous savoir que ces prix avant 2019 n’étaient pas pour QuartzClinical? Eh bien, il n’a été lancé qu’en janvier 2019, comme le montre ce « blog de revue » qui ne fait que répéter de manière transparente les communiqués de presse in extenso.

Ce qui nous reste, avec QuartzClinical est une description d’un logiciel qui semble combiner l’entreposage de données de plusieurs sources avec une couche analytique qui fournit ensuite des algorithmes d’aide à la décision. L’analyse est apparemment effectuée hors du site du client (car nous savons que Surgisphere affirme qu’il conserve toutes les données pour une utilisation future). Les sources de données comprennent à la fois les dossiers financiers et les dossiers de santé électroniques et nécessiteraient au minimum une ingénierie des données et des pipelines modérément complexes pour le déploiement. L’entreprise qui en est propriétaire n’a aucune capacité de gestion de projet TIC, de développement de logiciel, de déploiement ou de support. Il existe très peu de références à ce logiciel sur le Web, à part son propre matériel promotionnel. Il a une entrée dans venddy.com, un site qui permet aux vendeurs et aux acheteurs de systèmes de santé de se réviser mutuellement, mais sans avis d’utilisateurs. Le matériel promotionnel apparaît sur le Web à partir du début de 2019, nous savons donc qu’il a environ un an. Le propriétaire a un dossier d’exagérer son CV bien au-delà du point d’être trompeur (par exemple une mention honorable pour avoir donné un papier évolue avec le temps au Grand Prix de Qualité).

Quelle est la probabilité qu’un nouvel outil d’analyse de données basé sur le cloud, qui s’intègre aux systèmes de données les plus sensibles des hôpitaux (finances et dossiers de santé électroniques) et transfère ces données à travers les frontières internationales, passe de zéro à déployé dans 671 hôpitaux sur six continents en 12 mois, mais n’a pas encore d’avis d’utilisateurs et aucune discussion sur le Web de la part de responsables informatiques enthousiastes impliqués dans son déploiement? Zéro, c’est la probabilité; ou aussi proche de zéro que le nombre.

«Résultats chirurgicaux»

Ensuite, quelques mots sur Surgical Outcome, le réseau collaboratif international des clients QuartzClinical (hôpitaux et centres de santé) qui donnent leurs données à Surgisphere avec confiance. Voici le site Web des résultats chirurgicaux . C’est une étrange combinaison de battage médiatique sur l’apprentissage automatique et d’amélioration des processus en six sigma. Vous pouvez rejoindre le Collaboratif pour 295 $ par an et accéder à des ressources éducatives en ligne pour la formation médicale continue / le maintien de la certification. Ou payez 2 495 $ pour accéder à d’autres services tels que la participation à la «recherche collaborative».

Il existe de nombreuses captures d’écran d’un outil de veille stratégique, vraisemblablement QuartzClinical (qui est fortement promu) permettant à l’utilisateur d’explorer (par exemple) les procédures chirurgicales et de comprendre les inducteurs de coûts, accompagné de vidéos loufoques sur la puissance des données et l’importance des mesures de performance .

Il y a un blog franchement bizarre avec environ 100 articles, à partir de septembre 2019. Ils combinent des instructions statistiques de base sur des sujets tels que l’appariement des scores de propension avec des conseils de contrôle de la qualité et de gestion de projet. Certaines statistiques sont tout simplement erronées; un exemple choisi au hasard est cette capture d’écran qui nomme à tort les limites d’un intervalle de confiance «paramètres».

Vous et moi savons, cher lecteur, que ce n’est pas ainsi que les hôpitaux acceptent de partager les données personnelles des patients. En particulier, ce n’est pas la façon dont les hôpitaux d’autres pays décident de partager leurs données avec une entreprise aux États-Unis. Nous savons également qu’une «évaluation rapide de la technologie» n’est pas nécessaire avant de déployer une plate-forme analytique. Pas un qui tire des données des systèmes financiers et de DSE de l’hôpital, les stocke dans le cloud, effectue un apprentissage automatique et renvoie des recommandations de décision intégrées aux propres processus de l’hôpital.

L’article lui-même

Je n’ai même pas mentionné les problèmes de données que nous pouvons glaner directement à la lecture de l’article, si ce n’est en passant sur la proportion étonnamment élevée de cas hospitaliers en Amérique du Nord qui étaient dans l’échantillon. Plusieurs des erreurs les plus évidentes concernent l’Australie et ont été rapportées dans les médias. Par exemple, beaucoup plus de cas en Australie qu’il n’en existait au moment de l’étude, comme indiqué dans The Guardian . Surgisphere a répondu qu’un hôpital récemment rejoint (pourrait-il y en avoir un autre!) « S’est auto-désigné comme appartenant à la désignation continentale de l’Australasie … Cet hôpital aurait dû être plus adéquatement affecté à la désignation continentale asiatique. » Hmm, donc la base de données secrète a une qualité de données épouvantable mais bien sûr, des erreurs se produisent.

Mais comme le souligne Thomas Lumley , l’hôpital mal classifié devait avoir 546 cas de COVID-19 hospitalisés au 14 avril et se déclarer comme étant en Australasie. L’Indonésie avait déjà suffisamment de cas hospitalisés, mais il semble peu probable qu’il s’agisse d’une concentration de cette taille dans un seul hôpital. Et un hôpital indonésien se décrirait-il comme australasien (non, ce ne serait pas le cas). Et ces données pourraient-elles être partagées légalement avec une entreprise qui ne sait même pas quels pays doivent respecter les lois? (non ça ne pouvait pas).

Ensuite, le taux de tabagisme est trois fois plus élevé en Amérique du Nord qu’en Amérique du Sud; la petite fourchette de l’IMC moyen; les données détaillées peu plausibles pour l’Afrique; les données ethniques qu’il est illégal de collecter dans certains pays; et ainsi de suite.

Je ne veux plus écrire, cela me met en colère et me met en colère rien qu’en y pensant. Tout est mieux dit dans les liens en bas de la page.

Auparavant, j’avais plus ou moins suivi, mais je pensais qu’il y avait exagération quand les gens disaient «l’examen par les pairs est rompu», mais maintenant je le crois vraiment. À l’avenir, ma devise sera vraiment «publier les données et le code ou cela ne s’est pas produit» – pas seulement comme «c’est une bonne pratique» mais comme dans «si vous ne le faites pas, je dois penser que vous pourriez être inventer ». Avec des données sensibles, nous devrons trouver des moyens de fournir des versions synthétisées ou d’autres versions contrôlées par la divulgation.

La bonne nouvelle à propos de cet épisode est que cela a un peu fait taire les gens qui critiquaient cette étude d’anticorps de Stanford parce qu’il s’agissait d’une préimpression non revue par les pairs. Le problème avec l’étude des anticorps de Stanford n’est pas qu’il s’agissait d’une préimpression non évaluée par des pairs; c’est qu’il avait de mauvaises analyses statistiques et les auteurs n’ont fourni aucune donnée ou code.

J’espère que je me trompe sur tout ça. Peut-être que les développeurs ETL, le personnel de support et les spécialistes de l’intégration des DSE de Desai ne sont tout simplement pas sur LinkedIn pendant que ses vendeurs le sont. Peut-être que les hôpitaux partagent vraiment et avec plaisir nos données avec une entreprise américaine, et les données sont stockées sur des serveurs européens pour se conformer au RGPD et il y a même une autorisation patiente donnée quelque part qui n’a pas été mentionnée. Peut-être que QuartzClinical est intégré dans le logiciel d’une autre entreprise, il a donc été déployé dans 671 hôpitaux sans aucun examen ni discussion car sa marque est cachée.

Je me sentirais mal d’écrire un article aussi long et agressif que celui-ci dans ce cas. Mais cela semble très improbable. Il est affreux de penser que l’explication la plus probable de ce que nous voyons est simplement que les données sont fabriquées, dans ce qui est peut-être un complot criminel, et que le processus de publication scientifique est tellement brisé qu’il passe. Il me semble très probable que cette explication est la bonne.